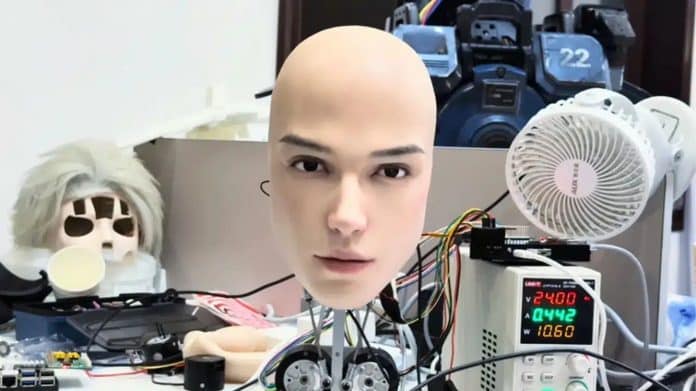

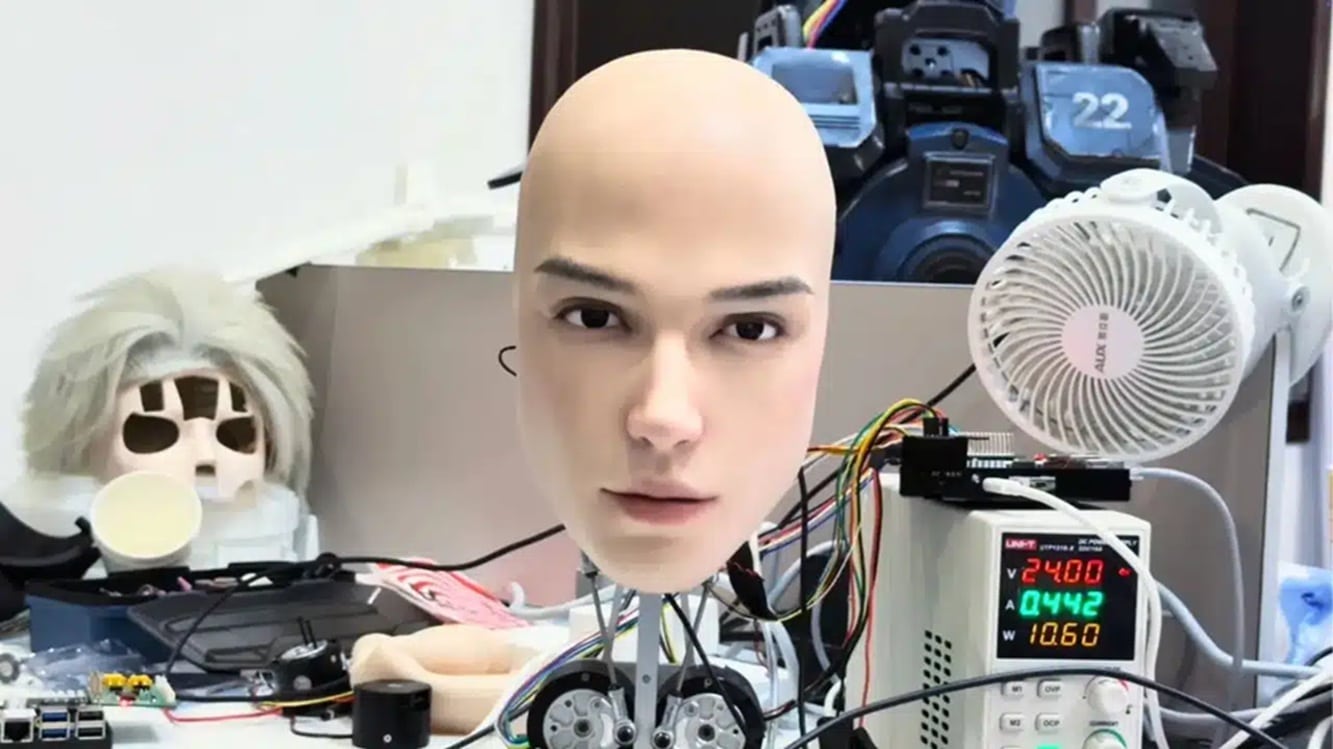

Tem notícia que dá frio na espinha e curiosidade ao mesmo tempo. A startup chinesa AheadForm exibiu um protótipo que muita gente jurou ser um ator disfarçado: o Only Head, da linha Origin M1. É exatamente o que o nome diz — apenas uma cabeça —, mas com expressões tão convincentes que o público oscilou entre aplauso e pavor.

Apresentado como plataforma de pesquisa em interação humano-robô, o modelo virou teste ao vivo de limites psicológicos. Em demonstrações e vídeos, ele pisca, sorri de canto, franze a testa, acompanha rostos com o olhar e sincroniza a boca com respostas de voz.

O efeito, visto de perto, destoa do que esperamos de um manequim robótico e lembra criaturas “quase humanas” do cinema.

Leia também: Ciclone de até 90 km/h ameaça cinco estados no feriado do Dia das Crianças; veja se o seu está na lista

Por trás do rosto artificial há 25 micromotores instalados sob uma pele sintética texturizada (poros, dobras, brilho de lábios). Esses atuadores controlam pálpebras, sobrancelhas, bochechas e comissuras, permitindo microexpressões rápidas.

Um conjunto de câmeras e microfones identifica vozes, direção do som e movimentos à frente; o sistema então fixa o olhar em quem fala e ajusta a expressão em tempo real — justamente o que dá a sensação de “presença”.

A reação pública tem uma explicação clássica na robótica: o vale da estranheza. Quando um artefato chega perto demais do aspecto humano, mas não chega a enganar por completo, o cérebro detecta pequenas inconsistências (ritmo do piscar, latência no sorriso, rigidez no canto dos olhos) e aciona desconforto em vez de empatia.

É o mesmo estranhamento de bonecos hiper-realistas e animações com movimento facial quase perfeito, porém ligeiramente fora de tempo.

Segundo a AheadForm, o objetivo não é assustar, e sim treinar interação social de máquinas: estudar quais sinais faciais aproximam e quais afastam as pessoas, alimentar modelos de IA afetiva e, no futuro, levar esse aprendizado a assistentes de saúde, recepção, atendimento público e educação. A empresa argumenta que expressões legíveis melhoram o entendimento e reduzem fricção em tarefas de contato direto.

Do outro lado, pesquisadores levantam alertas éticos. Quanto mais um robô parece compreender intenções humanas, maior o risco de superatribuição (achar que ele sente o que não sente).

Entram em pauta transparência de uso, limites para manipulação emocional, proteção de dados biométricos (rosto, voz, padrão de olhar) e sinalização clara de quando há um sistema automatizado do outro lado.

Nos clipes que circularam, o Only Head alterna olhar fixo, piscar lento e meio-sorriso — para alguns, demonstração técnica impecável; para outros, o tipo de cena que rende comentário “incrível… e eu não dormiria com isso no quarto”.

Seja qual for o lado, o protótipo cumpre um papel: expõe o ponto em que expressividade mecânica cruza a linha do conforto e pressiona a conversa sobre onde — e como — queremos conviver com rostos artificiais.

Leia também: Se a diferença de idade for essa, o relacionamento tem mais chances de dar certo, diz a ciência

Compartilhe o post com seus amigos! 😉